Data Grouping 군집

x변수가 많을수록 데이터는 분석하기에 유리해진다고 한다. 최근의 문제는 기존에 갖고 있는 변수가지고는 한계가 있는데 그 이유는 개인화된 데이터이기 때문이다. 방문한 접속 빈도수가 얼마나 되고, 가족 수가 몇명인지, 우리 물건을 어떻게 사갈까 세그멘테이션은 가능하지만, 개개인이 뭘 살지는 예측하기가 어렵다. 얼마나 버는지, 가족구성원, 경제상황, 건강상태 세부적인 내용을 모르기 때문에 그룹안에 넣어버리면 초개인화는 불가능하다. 세그멘테이션이라는 군집으로 안되는 것들을 어떻게 더 세그멘테이션 할 수 있는지 찾아야 한다. 리뷰의 내용을 가지고 개인화한다고 하면 국물이 흘렸다고 리뷰를 자주쓴다면 청결함, 까칠함, 우선시하는 것들을 볼 수 있다. 이런 것들까지 분석하는 최고의 도구가 RAG나 GPT인 것이다. 예전에도 있었지만 그때는 분석도 잘안되고, 비싸서 쓰지 못했다. 뭔가 음식물을 새는 것을 말할 수 있는데 이거를 단어셋으로 만들어놓고, 형태소 분석기/벡터화 하는 방법이 쉬워졌기 때문에 고객에 개인화된 데이터를 얻고 추천시스템에 넣을 수 있게 되었다.

우리가 회사가서 할일은, 사이언티스트는 차원의 저주문제를 풀어주는 PCA 를 풀어주는 일을 하고, AI기획자는 개인화에 초점을 맞춘다면 요소를 더 잘 찾아내야 한다. 내가 가는 곳이 물류/이커머스/금융 한 곳에 갔을 때 기존 데이터와 생성 데이터를 가지고 어떻게 한번 더 가공하거나 있는 데이터이지만 전혀 보지 않았던 부분을 고객의 개인화에 영향을 줄 수 있는 요소인지 찾아내야 한다. 데이터를 기술적으로 풀어나가는 사람이 있고, 데이터를 보고 기술자한테 ‘이 요소 넣었으면 좋겠어요.’라는 사람도 있다. 프로젝트할 때 인사이트 잡아야 하는데 니즈같은 걸 많이 봐야하고, 자기가 쓰면서 불편했던 것들을 찾아야 한다. 기획자들은 어떤 요소가 있는지 뽑아내는 일을 한다. 회사는 지네가 갖고 있는 데이터에서 새로운 인사이트를 뽑을 수 있는 사람을 필요로 한다.

개인화 추천시스템이 생긴 이유는 사람마다 너무 다르다는 것이다. 모든 데이터를 받기 용량이 부족하다. GPU는 초고속 연산기 이다.

PCA

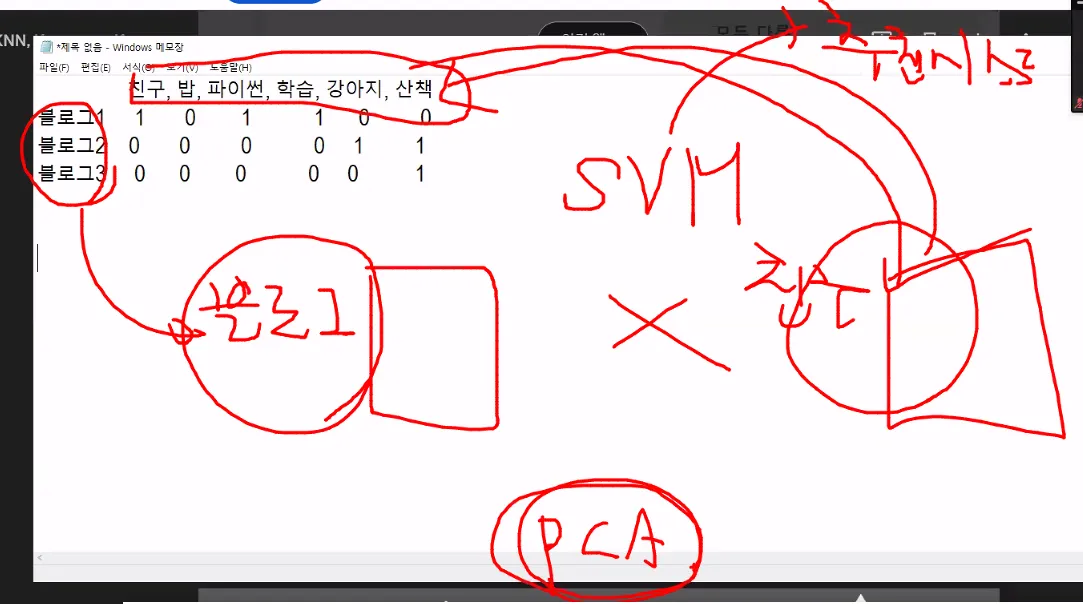

차원을 줄이는 방법론 중 하나가 PCA다. 차원을 줄여도 원데이터에 문제가 되지 않는다. 차원을 줄였을 때 수많은 벡터기법들이 있다. 이걸로 SVM(행렬분해)를 할 수 있다. SVM이 추천시스템이다. 넷플릭스는 위처럼 처리 못한다. 왜냐면 0값이 너무너무 많다. 예전에 넷플릭스 추천시스템 경진대회를 했었다. 추천시스템의 근간이 PCA다.

PCA 분석은 난이도 최상인 부분이다. 수학의 벡터를 잘 풀어나가야 하기 때문이다. 본인의 전공이 경제 통계 수학은 수학적으로 풀어볼 것을 권장한다.

PCA라는 것은 데이터 변수량이 너무 많을 때, 변수에 해당하는 것들을 묶어내는 방법이다. ‘특징 선택(Feature Selection), 특징 추출(Feature Extraction)’ 구글에 검색해본다. 통계학적으로 풀어나가는지 아닌지를 보는 것이다. PCA는 특징 추출에 해당한다. 요소 몇개를 뽑아내는 것이다. ‘특징 선택 다중공선성’을 검색한다. 특징을 선택할 때 미래데이터를 예측하는 회귀분석이나 미래데이터를 예측해서 어디에 속할지 분류 분석과 같은 머신러닝이라고 하는 기계학습이다.

회귀분석과 분류분석

어디에 속할 것 같은지 찾는 것이 분류 분석, 꽃 3종류 중에 어디에 속할 것 같은지 찾는 것이 분류 분석이다. 타이타닉에 들어가는 데이터셋을 가지고 선실을 등급이나 가족이랑 탔는지 친구랑 탔는지를 가지고 생사의 유무를 찾고 싶을 때 분류분석이다.

집값이 얼마일것 같은지, 매출이 얼마 나올 것 같은지는 회귀분석이다.

이 작업에 들어가는 x 변수가 있고, x 가지고 계산을 한 다음에 Y는 함수식이다. 계산을 할 때 어떤 계산 공식을 쓸 것인지에 따라서 SVM도 가능하고, 회귀분석도 가능하고, 랜덤 포레스트도 가능하다. 정형데이터 ML은 수많은 공식을 가지고 뽑아쓰는 것이고, 인경신경망은 공식 하나 줄테니까 거기 안에서 해결하라는 것이다. 기존의 머신러닝은 엄청 많은 수학 공식이 있고, 이 공식 중에 나랑 가장 맞는 공식이 뭐가 있을지 찾아내는 것이다. 20개 정도 모델들이 다 낱낱이 알고, 이 케이스에 맞는지 본다.

내가 일일히 할 필요가 없고, 컴퓨터에 주고 맞춰보라고 한다. 맞출 때 옵션값들(SVM, 회귀, 랜덤)이 많다. 그러면 컴퓨터한테 다 해보라고 시킨다. 모델 10개/20개 밖에 안된다. 이거를 다 돌려보고, 그 안에 있는 옵션값 다 돌려본다. 자동화되어있는 머신러닝도 있다. 오토ML이라고 한다. 사이즈가 많은 데이터를 넣으면 금액이 많이 든다. 기술과 관련된 것들은 기술로 풀어낼 수 있지만, 무한대의 데이터를 넣을 수 없기 때문에 표본추출 어떻게 할지도 고민의 대상이고, 구글 AWS IBM 등 갖고 있는 유수의 오토ML이 우리와 맞는지도 봐야한다. 오토ML 되게 좋지만 변수를 최대한 적게 넣어야 한다. 컴퓨터의 성능에 한계가 있기 때문에 어떻게든 변수량을 줄여야 한다.

반려동물 유무라던지, 특징값이 많으면 좋다. 하지만 x변수에서 누가봐도 연관있는 것은 필요없다. 비와 우산유무처럼 당연한 것들. 너무 연관있는 변수는 안쓰겠다고 하는 것이 다중공선성이다. x들끼리의 상관도가 너무 높으면 안쓰겠다고 하는 것이다. 나이가 많으면 돈을 많이 번다는 것 같은 것은 상관계수가 너무 높아서 굳이 x변수로서 둘다 존재할 필요가 없다라는 것을 통계학적인 방법으로 찾아내는 것이 다중공선성이다.

y값을 결정하는데 있어서 필요한 x값은 뭐냐? 하나씩 넣어서 x값을 계속 본다. 나이에 따라 취업이 변하나, 지역에 따라 성별이 변하나, 이렇게 변수를 하나씩 넣어서 y값을 보는 방법이 있고, 또 다른 방법으로 후 (정답이 없다. 얼마나 결합을 잘 시키는지가 이슈이다.)

특징추출: 고차원데이터를 저차원 형태로 변환하는 방법론이다. 프로그램 상으로는 쉽게 나와있지만 수학적으로는 많이 어려운 쪽에 해당한다. 벡터값을 나누고 합치고 원데이터를 유지시켜야해서 분산, 공분산 들어가있는 파트이다. 특징추출과 관련되어있는 머신러닝 모델은?

‘PCA 집값 예측’ 변수값이 많을 때는 변수의 일정한 부분을 없애야 한다. 파이썬으로 작업을 하지만 지금 여러 모델들은 kmeans 같은 것들은 Azure에서 사용하겠다고 하면 모델을 사용하는 프로그램들이 다 있다. 드래그앤드롭만 하면 된다. 알아서 다 만들어준다. 프로그램들이 드래그만 하면 되는 걸로 만들어져있다. 어떤 모델, 어떤 변수 쓸지만 정해주면 나온다. Azure도 되고, 삼성에도 있다.

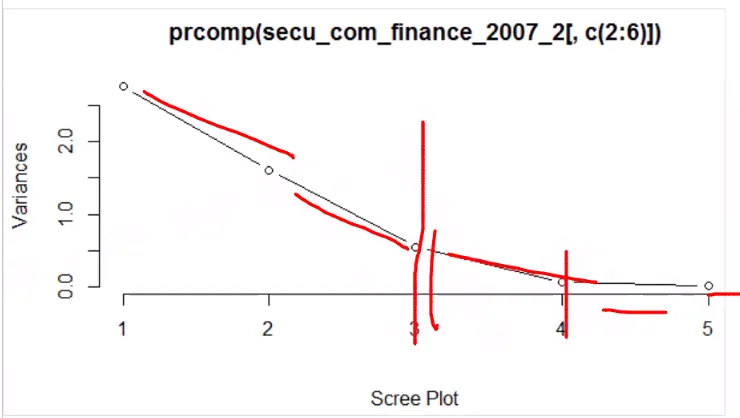

PCA 목적은 변수가 12개 인것을 변수를 줄이겠다라는 것이다. 근데 또 변수를 6개 만드면 의미가 뭐냐는 거다. 그래서 무조건적으로 하는게 아니라 2개정도 한다. 벡터가 어느정도 값이 들어와야 한다. PCA는 문법보다는 해석을 잘해야한다. 이 값들을 어떻게 해석할지가 중요하다.

R이 파이썬보다 머신러닝 시각화가 잘된다. 지피티가 없었으면 R Friend에 많이 접속했을 것이다. 응용보다는 베이직 문법들이 잘 나와있다.

R은 코드를 쓰는 것보다 해석을 잘해야한다. 회사에서 R 능력을 요구한다면 숫자들을 보고 얼마나 잘 해석할 수 있는 능력이 있는지를 보는 것이다.

R은 서울시 강동구, 서울시 강서구 이 문자를 나눠도 된다고 미리 얘기를 해줘야한다. stringAsFactors

파이썬은 이런 것을 가리지 않는다. 여기에서는 factor인지 아닌지를 따진다. 데이터 들고 들어올 때 문자열로 가져오라고 한다. 이거는 기획설계 하는 사람들이 잘 이해해야하는 부분이다. 프로그래머들은 이 부분을 알고 있다. 그리고 신경을 잘 안쓴다. 기획 설계 하는 사람들은 우리가 주소 데이터를 받으면 이 데이터셋을 지역을 나누고, 시도별로 나눠서 해야하는 문자열이라는 걸 알려줘야 한다. 이 자료를 할때 그대로 유지해서 분석할지 아니면 가공을 해야하는 상황인지 명확하게 봐야한다. 가공은 조건문을 넣어서 정제한다. 어떤 방법으로 텍스트를 나눌 것인지 규칙을 줘야한다. 빈칸 단위로 데이터가 나눠질 수도 있다.

산점도를 확인하면 두 변수간 상관이 있는지 확인할 수 있다. 엑셀로 보는 산점도 이용한다. 엑셀에서도 가능하지만, 한눈에 볼 수 있는 차트를 그려주면 되는데 파이썬은 맷플럿을 써야하는데 R은 plot을 준다.

V1에 해당하는 데이터가 이만큼있다고 하는 거다. PCA를 몇개 넣어야 전체데이터를 소화할 수 있을까?를 확인하는 것이다. PCA를 몇가지로 해야하는지 보면 두번째 PC1, PC2를 쓰거나, 세번째는 PC3를 보통 쓴다. 99프로는 너무 크다. 그리고 11프로는 너무 작다고 판단했다.

PCA 처음에 할때는 분산 큰 자료끼리 모을 것을 찾는다. 다른 데이터들 모으는 것이다. 다른 x변수끼리 모으는 것이다. 분산이 큰 자료를 한세트로 만든다. 분산1(PC1)이 분산이 크다.

여기서 우리가 해야할 일은 V1,V2를 묶어서 V1이 여기에 0.77, 0.56 값이 큰게 들어가있다. PC2의 설명하는 것은 V1,V2라고 하는 거다. PC1을 안정성이라는 특징을 추출해서 새로운 변수를 만든다는 얘기다.

아래가 사람이 하는 일이다.

방향성을 보고 어떤 증권사가 특이점이 있는지 알아보는 것이다. kmeans 안가고 여기서 분석 끝내는 경우가 있다. 파이썬은 이만큼 시각화가 안나온다. R에서 더 잘나온다.

출처: https://rfriend.tistory.com/61

주성분 분석 해석을 어떻게 할 것인가?

https://rstudio-pubs-static.s3.amazonaws.com/398326_7e179775c2c948189f5b457cceabed59.html

주성분분석(PCA: Principal component analysis) with R

rstudio-pubs-static.s3.amazonaws.com

지피티로 R코드를 파이썬 코드로 바꿔달라고 시키면 잘해준다. 프로그램과 프로그램 변환에도 지피티가 쓰인다.

R 쓸 수 있냐고 물어보면 코드만 변환시키면 되는데, 프로그램의 스타트가 조금 다르고 R 기초문법이 조금 달라서 그 부분 정도만 학습하면 된다. R의 좋은점이 모듈을 별도로 안넣어도 되고, 알아서 변수가 어떤 성격을 가지고 있는지 보여주기도 하고, decsribe 통계요약을 잘해준다.

데이터값을 엑셀로 가져와서 Min Max를 확인한다. 폭행이 가장 경범죄이기 때문에 도시마다 스케일이 다를 수 있다. 도시근로자 중에서 사무직군이 아니라 직군이 다른데가 많은 데서는 폭행이 많이 나올 수도 있기 때문에 폭행에 관련된 것은 여기서 굳이 산점도 안봐도 된다. 변수를 가지고 폭행에 대한 변수가 당연히 기본적으로는 데이터값에 대한 산점도가 넓을 것이라는 뜻이다. 중대 범죄들은 데이터의 산점도가 덜할 것이다.

그렇기 때문에 폭행이 가장 큰 분산 값을 지닌다. 도시 인구 밀집도에 따라서 2개 또는 3개까지 군집하면 PC 3개가 너무 작으면 PC2 까지만 분석해도 된다.

PC1,PC2에 대한 값을 보면 살인이 많은 도시들이 있고, 데이터값들을 갖고 확인을 했을 때 라는 것이다.

( 파이썬에서 실습 )

인덱스키이면 검색속도가 빨라져서 인덱스 키인지 먼저 확인해라. 맨 처음 데이터베이스 설계할 때 인덱스 키를 설정한 것은 대부분 변하지 않는 것들이다. 아래는 내가 검색을 했을 때, 각각의 이름들 자체가 중복도 없어서 인덱스 키로 뺀 것이다.

이 자료를 보고 정규화 여부를 확인한다. min max 값을 본다.

요즘 최대 화두되는 이슈는 RAG해서 어시스턴트 만드는 것이다. 내가 질문을 했는데, 이거를 GPT가 해주면 되는 것이다. 많이 질문한 리스트를 받아와서 지피티가 그 데이터를 갖고 있기 때문이다. 거꾸로 해주면 된다. 프로그램적으로 구성은 못해도 어시스턴트의 역할을 어디까지 받아야할 것인지에 대한 고민을 과정 끝날때즘에는 해야한다.

데이터를 업로드하고, 이걸 기반으로 어시스턴트를 해줘라~ 라고 하는 거다.

지피티에 들어가있는 수많은 질문은 DB화 하는 것이 좋을 수도 있다. 회사에서 뭔가를 구성한다면 지피티를 가지고 데이터를 pdf를 쓰던간에 필요한 직군이 있을 수도 있다. 필요한 사람들에게 GPT로 작업을 해보게하고, 질문지들이 만들어질 것이다. 질문지를 가지고 초보자들에게 어시스턴트가 될 수 있도록 도와줄 수 있다. 도메인 지식을 무턱대고 알려주는 것이 아니라 어시스턴트로 만들어서 비서역할을 해주는 것이다. 기술적으로 어렵진 않은데 요구사항이 어떤 것이냐에 따라서 어려울 수 있다.

GPT작업에 데이터를 올려서 업로드하는 순간 질문을 어시스턴트 할 것이다. 어떤 작업이세요? 이렇게 물어볼 것이다. 데이터 분석을 하는데 너가 어시가 됐으면 좋겠어. 라고 하면 지피티가 데이터 형태를 알려주고, 데이터 분포도 먼저 확인해 보시겠어요? 이렇게 질문을 한다. 가이드를 일정량한 다음에 해줘서 보여주고, 결과 만족하시나요? 이렇게 거꾸로 왔다갔다 할 수 있는 것이 어시스턴트 역할이다. 어떤 일을 할지 알아야 한다. 산점도를 꼭 봐야해. 이거를 알아야 한다. 지피티가 기본적인 것은 어시스턴트 역할을 잘할 것이다. 데이터 분석 조력자로서 나한테 해줄 수 있는 시나리오를 짜줘봐. 하고 다시 학습을 시켜도 된다. 이런 부분에 대해 계속적으로 고민을 해야한다. 문제는 쓰는 사람이 못쓰니까 쓰는 사람들을 위해서 개인화하는 작업들을 잘할 수 있게끔 보조 도구를 만드는 것이다.

요즘 판매하는 데이터에 단순하게 숫자나 문자 데이터만 보는 것이 아니라 일의 처리 순서도 팔기도 한다. PCA를 하면 기본적으로 데이터 정비를 하는게 프로세싱이다. 회사 내에서의 어려운 일의 프로세싱과 관련된 일도 더 큰 중요한 것으로 여긴다.

분산 값 계산이 중요하다.

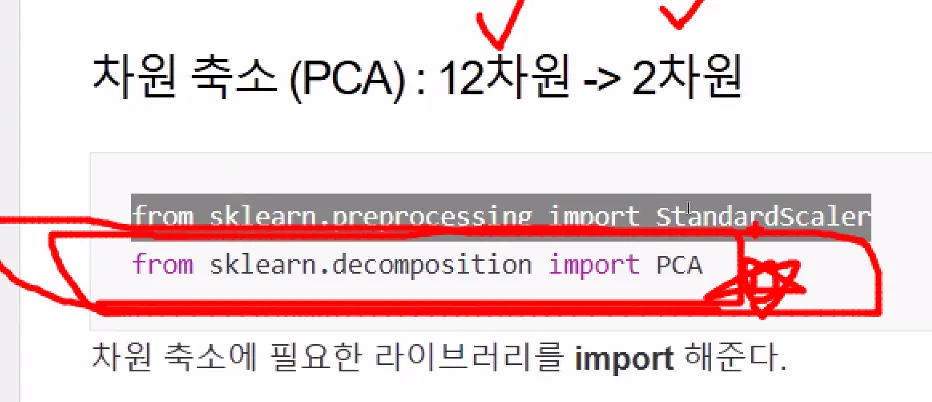

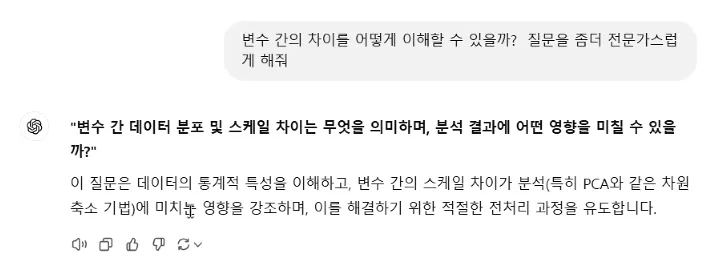

데이터 스케일링이 어떤 영향을 주냐는 질문에서 시작될 수 있다.

fit = 피팅한다.

주성분 분석을 떠나서라도 스탠타드스켈러의 공식은 평균과 편차를 가져와야 하기 때문에 기본적으로 x변수에 따르는 전체 데이터의 평균이 들어간다. 표쥰편차 대비 평균값이 들어간다. fit은 이 값을 계산하기 위해 평균과 편차를 계산한 것이다. 스탠타드스컬러는 편차와 평균값이 있어야 해서 이거를 계산한 것이다. 계산이 되는 것은 아니다. 스켈러 데이터를 갖고서 transform을 해줘야 한다. fit하는 과정은 식에 들어갈 편차와 평균값을 계산하는 것이고, 최종적으로 transform을 해야 변경이 된다.

트레인 데이터는 fit하고 transform하는데, 테스트 데이터는

정규화가 만만한게 아니다.. 한개 데이터로 하면 문제가 안되는데

훈련데이터는 모델을 만들고, 이 모델 안에 넣어질 데이터가 테스트 데이터다. fit transform을 앞으로 많이 볼 것이다. fit은 필요한 변수를 제작하는 과정이고, transform은 그 값을 넣어서 대입해서 원래 데이터를 바꾸는 과정이다.

역행렬

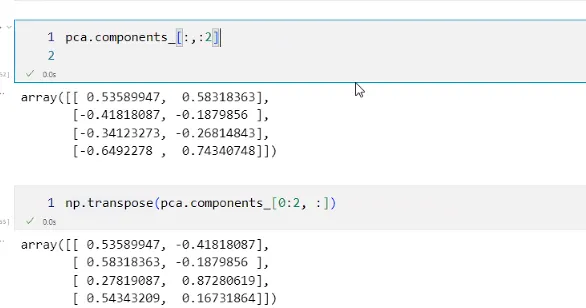

파이썬은 아래와 같은 과정을 거쳐야 한다.

이거를 가지고 차트를 그리려고 한다. PCA 관련되어있는 코드 많지가 많다. 코드가 이해가 되야한다.

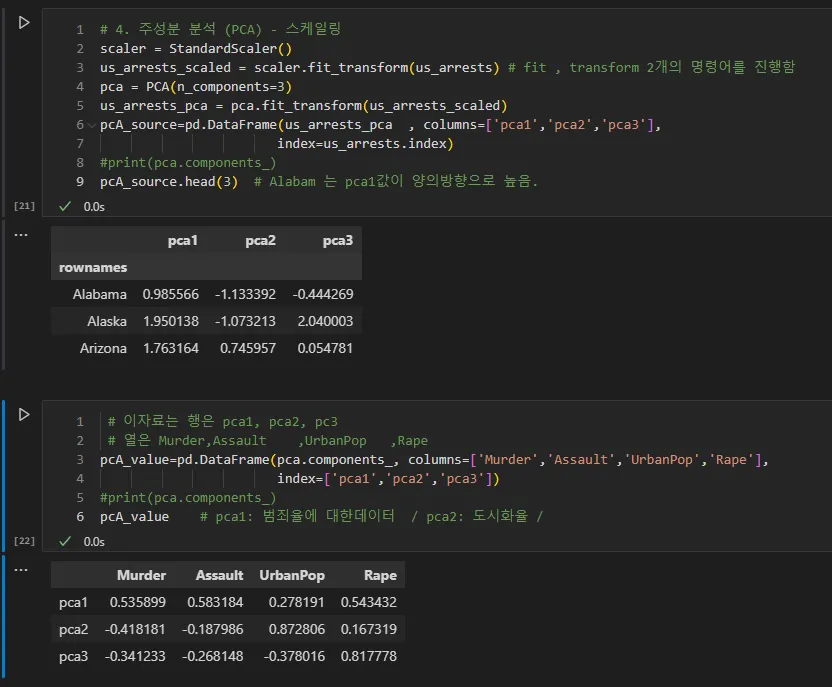

PCA1은 살인, 폭행, 강간에 대한 범죄율이 양의 상관관계를 보일 것이다.

Alabama는 그룹으로 분류했을 때 범죄율과 관련된 그룹을 하나 만드는 것이다. 높은 범죄율을 보이기 때문이다. 다른데이터 대비해서 PC1값이 높은 것이 Alabama, Arizona, California 들이 높다. PCA1은 범죄율에 대한 데이터 / PCA2는 도시화율 / PCA3이

PCA2 그룹은 도시화가 잘 된 도시다. 도시화와 나머지 3개 범죄는 다른 것을 의미한다. 연관성을 찾기 어렵다고 해석하고, 독립적인 것으로 해석한다. 연관성 찾기가 살인을 적게 한다고 강간을 많이하나?는 아니라는 것이다. 도시화가 되었다고 강간이 없는건가? 아니라는 것이다. 미국 지역 특성을 고려해야한다. Alaska는 완전 따로 떨어진 도시이다. 독립적인 사건인지 아닌지를 구분한다.

PCA만으로도 군집 처리를 할 수도 있다.

해석이 어렵다고 하다면 이 작업을 해서 gpt한테 PCA 결과물 주고 해석해달라고 한다.

코드는 아래

💡 PCA(주성분 분석)는 데이터의 차원을 축소하면서 주요한 패턴을 유지하는 기법입니다. 업로드된 결과를 한국어로 해석하면 다음과 같습니다:

주요 결과

PCA Source (pca_source):

이 데이터프레임은 각 주(State)가 주성분(pca1, pca2, pca3) 상에서 변환된 값을 보여줍니다.

예: Alabama: pca1 = 0.985566, pca2 = -1.133392, pca3 = -0.444269 Alaska: pca1 = 1.950138, pca2 = -1.073213, pca3 = 2.040003

이러한 값은 각 주가 새로운 주성분 축(pca1, pca2, pca3)에 투영된 좌표를 나타냅니다. 높은 값일수록 해당 주성분에서 더 큰 기여도를 나타냅니다.

PCA Component Loadings (pca_value):

이 데이터프레임은 각 변수(Murder, Assault, UrbanPop, Rape)가 각 주성분(pca1, pca2, pca3)에 얼마나 영향을 미치는지를 나타냅니다.

예: pca1: Murder = 0.535899, Assault = 0.583184, UrbanPop = 0.278191, Rape = 0.543432

이는 pca1이 주로 Murder, Assault, Rape와 강하게 관련이 있음을 의미하며, 전체 범죄율을 나타낼 가능성이 큽니다. pca2: UrbanPop = 0.167319이 영향을 주지만, Murder와 Assault도 중요한 영향을 미칩니다. pca2는 도시화 경향과 관련이 있을 수 있습니다. pca3: UrbanPop과 Rape가 큰 기여도를 가지며, 이는 사회적 또는 인구학적 경향을 나타낼 가능성이 있습니다.

해석

pca1: Murder, Assault, Rape와 강한 상관성을 가지며, 범죄의 강도를 대표하는 주성분으로 해석됩니다. pca2: UrbanPop(도시 인구 비율)과 다른 변수의 영향을 일부 받으며, 도시화 또는 지역적 특성을 나타낼 수 있습니다. pca3: UrbanPop과 Rape의 기여도가 높아, 사회적/인구학적 특성을 반영할 가능성이 있습니다.

관찰

Alabama와 Alaska 같은 주는 pca1 값이 높아 범죄 수준이 높은 지역으로 해석됩니다. pca2와 pca3 값은 도시화나 특정 인구학적 특성에 따라 주들을 구별합니다.

차원축소(PCA) 파이썬 예제 - 범죄율과 집값 연계성

https://silvercoding.tistory.com/62

[boston 데이터 분석] 1. 차원축소 (PCA) 파이썬 예제

러닝스푼즈 수업 정리 라이브러리 & 데이터 불러오기 - 라이브러리 불러오기 import pandas as pd import matplotlib.pyplot as plt import seaborn as sns - 데이터 불러오기 data = pd.read_csv('./data/boston.csv') data.head() -

silvercoding.tistory.com

약간의 음의 상관관계가 있다는 것이 확인되었다. 범죄율은 집값에 영향을 준다. Y=f(x)하는 회귀분석에서 영향이 있다고 본다.

음의 상관관계를 갖고 있다는 것을 갖고 있고, 방의 개수가 많은 곳의 집값은 높을까? 방개수가 많아질수록 집값이 높아지지만, 가운데에 속하는 것을 분류할 수도 있다. 분류할 수 있는 수학적 근거가 된다.

아래 그래프는 음의 상관관계를 갖는다.

수학적지식과 도메인지식이 있어야 이해를 할 수 있다.

PCA 집값 예측 - 구글검색

보스톤 집값 예측이 제일 많이 나온다.

PCA K-means - 구글검색

어떻게 PCA를 K-means를 접목시킬 것인가? 단지 이거를 R로 할지, 파이썬으로 할지 결정한다.

실습) PCA (유성준 et al. 파이썬을 이용한 빅데이터 분석, p.354-359)

``` %matplotlib inline import matplotlib.pyplot as plt from sklearn import datasets from sklearn.d…

wikidocs.net

→ 내용은 MIS에 가깝다고 한다. 왜?? 나 MIS 뭐한거지?

PCA로 고객 세그멘테이션 하는 것, 인사관리

실제적인 예제들보다 재미없는 옛날 예제들로 많이 보일 것이다.

캐글에 PCA 검색하고 왼쪽 슬라이서에서 프로그래밍 언어 Python 선택

우리는 클러스터링과 관련있는 PCA를 보면 좋다. 또는 K-means와 연관되어있는 PCA

기본적으로 PCA와 연관되어있는 고객분류 (K-means) 살펴보자.

데이터분석 일하면 EDA 80-90프로다. 100페이지 중에 그 중에 10페이지만 모델링이고, 전부다 EDA다. EDA 하다보면 데이터가 보인다.

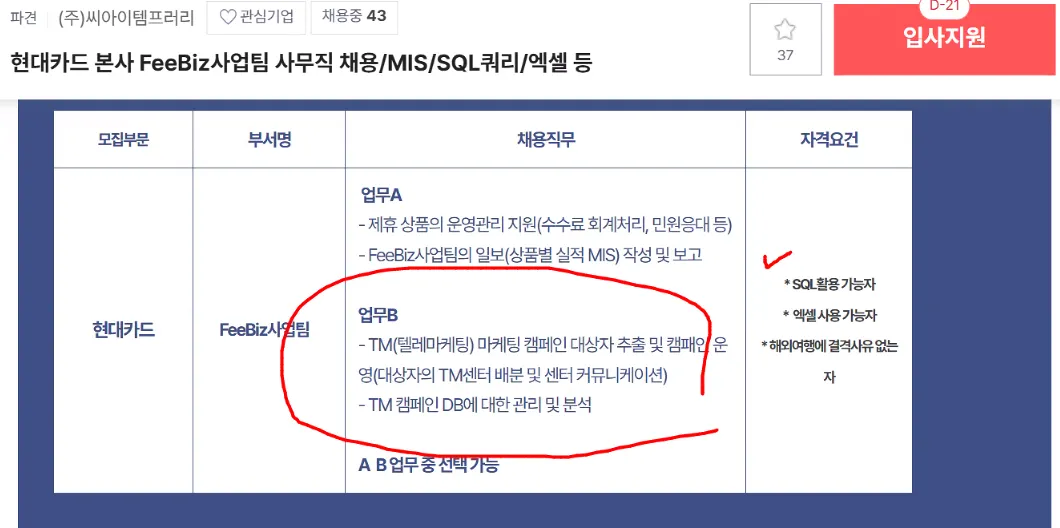

사람인 공고분석

담당업무 내용이 프로젝트 제목이 될 수가 있다.

신문기사나 키워드가 되는 것들을 뽑아서 유사도가 비슷한 내용을 붙이겠다. 라고 하면 된다.

SQL은 대부분 파견직, 계약직이다.

인턴을 하더라도 데이터와 연관이 된다면 찬성이다. SQL로 미친듯이 작업한다면 좋다. 인턴을 붙잡는다. 데이터를 본다는 것이 힘이 있단 것이다. 우리 데이터 다 봤는데 어딜가니. 이러면서 잡는다.

현대카드에 어떤 이슈가 있는지, 다양한 프로모션들이 진행하고, 수수료 회계 처리, 가짜 데이터를 넣어보면 되는 수수료에 대한 부분이 있다. 상품별 실적을 보고한다.

우리는 GPT를 통해 자동화된 보고서를 만들 것인지, SQL로 뽑아내는 것만 할지, 기획까지 할지가 다 다르다.

주제잡을 때도 구인란에 해당하는 것을 확인해보면서 CRM과 관련되어 있는 고객관리, 데이터분석 아니여도 된다. 주로 해야하는 일이 뭔지 보면 된다.

VIP고객 다룰 수 있는 방법론 작업한다. 지금은 MS만 가지고도 데이터 분석을 할 수도 있다 (적어도 한국은).

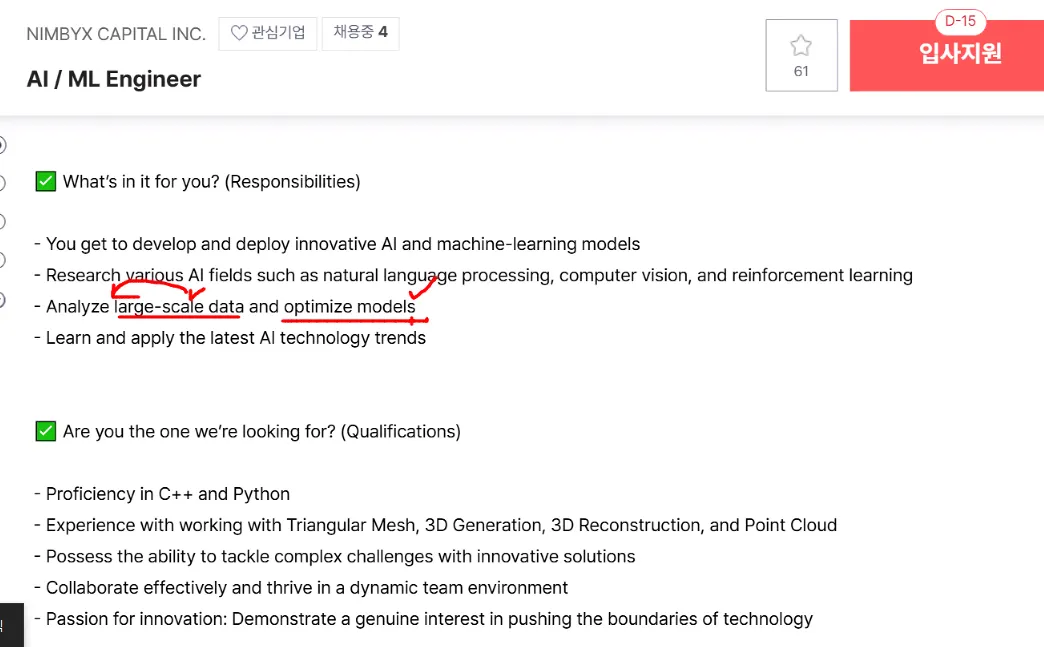

우리가 하는 파트는 머신러닝 ML 이다. 머신러닝과 관련있는 부분들은 AI / ML Engineer 가 나온다. 이것도 통계가 주인지, 데이터가 주인지 달라진다. 머신러닝 모델을 디벨롭하고 리서치 작업을 하는

이거는 우리랑 안맞는 거다.

ML부분이 열어서 들어가봐야 안다. 통계가 우선인지, 프로그래밍이 우선인지 다 다르기 때문이다.

'데이터 AI 인사이트 👩🏻💻 > KPMG 교육' 카테고리의 다른 글

| 비즈니스 애널리틱스 II (6) 회귀분석, XGBoost 등 최신 빅데이터 기법 (0) | 2025.02.13 |

|---|---|

| 비즈니스 애널리틱스 II (5) 분산, 공분산, PCA, 추천시스템 (0) | 2025.02.10 |

| 비즈니스 애널리틱스 II (3) K-means, 유사도 계산, 단위 벡터 (0) | 2025.02.10 |

| 비즈니스 애널리틱스 II (2) 넘파이, 군집분석(K-means), 클러스터링 (0) | 2025.02.10 |

| 비즈니스 애널리틱스 II (1) 랭체인, 판다스 AI 보고서 작성, 생성형 BI, Numpy (0) | 2025.01.26 |